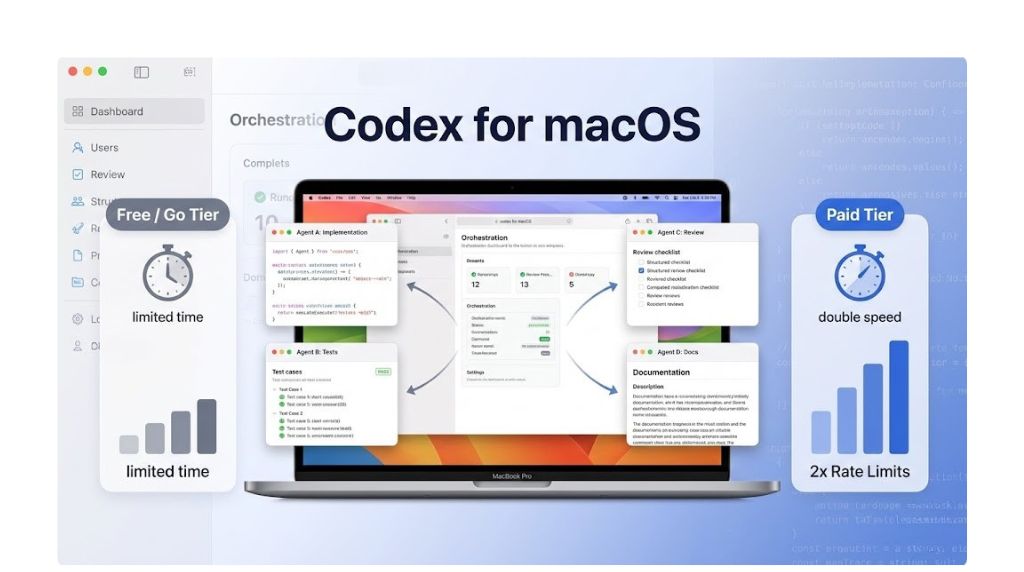

OpenAI vient de lancer l’app Codex pour macOS, avec une promesse simple mais structurante : sortir le coding assisté de l’IDE/terminal unique et permettre d’exécuter plusieurs agents en parallèle. Concrètement, au lieu d’une seule “conversation” qui tente de tout faire (écrire du code, corriger des tests, documenter, refactor, auditer), vous orchestrez plusieurs agents spécialisés qui travaillent en même temps sur des tâches distinctes. En parallèle, Codex est désormais inclus brièvement pour les utilisateurs Free et Go, tandis que les offres payantes bénéficient de rate limits doublés sur l’app, le CLI, l’IDE et le cloud. Cet article vous explique comment en tirer parti, comment structurer vos workflows, et quoi mettre en place dès aujourd’hui pour gagner en vitesse, en qualité et en fiabilité.

Ce que change l’app Codex sur macOS (au-delà d’un simple client)

La nouveauté la plus importante n’est pas “Codex sur Mac”, mais l’approche orientée “multi-agents”. Dans un environnement classique, vous pilotez une seule assistance dans l’IDE ou le terminal. Cela crée un goulot d’étranglement : chaque étape dépend de la précédente, la context window se remplit vite, et la qualité peut baisser lorsque trop d’objectifs se superposent.

Avec des agents parallèles, vous découpez le travail comme une mini-organisation : un agent prépare un plan, un autre applique un refactor, un autre écrit des tests, un autre effectue une review, pendant qu’un dernier rédige une documentation ou un changelog. L’enjeu n’est pas seulement d’aller plus vite, mais d’obtenir une meilleure “hygiène” du code : décisions explicites, validations systématiques, feedback loops plus courts.

Pourquoi le parallèle est un avantage compétitif

Le parallèle réduit le temps d’attente et améliore le taux de réussite. En pratique, vous pouvez faire travailler un agent sur l’implémentation pendant qu’un autre prépare la stratégie de tests, ce qui évite le piège du “j’ai codé, et maintenant je découvre que ce n’est pas testable”. De la même manière, vous pouvez lancer un agent “lint/format + quick fixes” pendant qu’un autre prépare une review orientée sécurité.

Sortir des contraintes IDE/terminal : une nouvelle couche d’orchestration

Quand tout reste “coincé” dans l’IDE/terminal, vous avez tendance à confondre production (écrire du code) et pilotage (organiser les tâches, vérifier, arbitrer). Une app dédiée peut jouer le rôle de cockpit : elle vous aide à assigner des missions claires, à suivre les sorties, et à consolider les résultats avant de committer.

Disponibilité et offres : Free/Go vs paid tiers, et l’impact des rate limits doublés

OpenAI indique que Codex est inclus brièvement pour les utilisateurs Free et Go. Cela implique une fenêtre d’essai ou une disponibilité limitée dans le temps, utile pour valider votre workflow et mesurer le ROI. Pour les offres payantes, les rate limits sont doublés à travers l’app, le CLI, l’IDE et le cloud. En clair, vous obtenez plus de capacité d’exécution et moins de friction quand vous lancez plusieurs agents ou des tâches lourdes (analyse de repo, génération de tests, refactor étendu).

Ce que “rate limits doublés” change réellement dans un workflow multi-agents

Le multi-agents peut saturer rapidement les quotas si vous lancez plusieurs tâches gourmandes en même temps. Des rate limits plus élevés permettent :

1) d’augmenter le nombre de tâches parallèles sans ralentissements ;

2) de réduire les compromis sur la profondeur (tests plus complets, analyses plus longues, meilleures explications) ;

3) de standardiser un process où chaque change passe par une phase de review automatisée et de tests générés, au lieu de “faire au plus vite”.

Comment décider si une offre payante est justifiée

La question à poser est opérationnelle : combien de temps gagnez-vous par semaine, et combien d’erreurs évitez-vous ? Si vous utilisez Codex pour des tâches récurrentes (mise à jour de dépendances, migration d’API, écriture de tests, refactor de modules), le plafond de rate limits devient un facteur de productivité. Si votre usage est sporadique, la période d’inclusion Free/Go peut suffire pour des besoins ponctuels.

Workflows actionnables : comment organiser vos agents en parallèle

Le piège classique est de lancer “plusieurs agents” sans cadrage, ce qui produit des résultats incohérents ou du travail en double. La clé est d’appliquer une structure simple : un objectif, des contraintes, un livrable, et un critère d’acceptation par agent. Voici des scénarios concrets à reproduire.

Workflow 1 : implémentation + tests + review en parallèle

Objectif : livrer une feature sans sacrifier la qualité.

Agent A (Implementation) : vous lui donnez un scope précis et un point d’entrée (fichiers, fonctions, endpoints). Livrable : code compilable + notes sur les choix techniques.

Agent B (Tests) : vous lui demandez d’écrire des tests unitaires et/ou d’intégration couvrant les cas nominaux et les edge cases, avec une exigence de lisibilité et de déterminisme. Livrable : suite de tests + instructions pour les exécuter.

Agent C (Review) : vous lui demandez une review structurée : architecture, complexité, sécurité, gestion d’erreurs, performance, et cohérence stylistique. Livrable : liste de changements requis vs optionnels, avec justification.

Action finale : vous consolidez. Si l’agent Review demande des changements, vous relancez soit l’agent Implementation sur un patch, soit l’agent Tests si les cas ne sont pas suffisants.

Workflow 2 : refactor sécurisé avec garde-fous

Objectif : réduire la dette technique sans casser le comportement.

Agent A (Cartographie) : mission de repérer les “hot spots” (fonctions trop longues, duplication, couplage, complexité cyclomatique) et proposer un plan par étapes.

Agent B (Refactor) : exécute uniquement l’étape 1 du plan, pas plus. Livrable : diff minimal, avec explication des invariants.

Agent C (Validation) : vérifie que les tests existent, propose des tests manquants, et identifie les risques de régression. Livrable : checklist de validation.

Action finale : vous appliquez une règle : pas d’étape suivante tant que la validation n’est pas verte. Ce mécanisme transforme le refactor en processus fiable.

Workflow 3 : migration de dépendances ou d’API

Objectif : migrer vite, avec un plan clair.

Agent A (Audit) : identifie où la dépendance est utilisée, quelles versions sont concernées, et les breaking changes à anticiper. Livrable : inventaire des occurrences + plan de migration.

Agent B (Execution) : applique les modifications mécaniques (imports, nouveaux appels, nouveaux types). Livrable : patch + commandes de build/test.

Agent C (Docs) : met à jour README, notes de release, ou documentation interne. Livrable : documentation alignée sur la nouvelle version.

Action finale : vous validez en CI. Si des warnings apparaissent, vous les traitez en boucle courte avec un agent dédié.

Bonnes pratiques : brief, contraintes et critères d’acceptation

Un agent produit de meilleurs résultats quand vous le traitez comme un contributor avec un cahier des charges clair. Le multi-agents amplifie ce besoin : sans cadre, les agents divergent. Voici comment écrire un brief efficace.

Le template de brief à réutiliser

Vous pouvez reprendre cette structure à chaque mission :

1) Contexte : objectif produit et contexte technique (langage, framework, conventions).

2) Scope : fichiers/dossiers concernés, et ce qui est explicitement hors scope.

3) Contraintes : style, compatibilité, performance, sécurité, dépendances autorisées ou interdites.

4) Livrable : ce que l’agent doit rendre (diff, tests, doc, checklist).

5) Critères d’acceptation : comment vous décidez que c’est “done” (tests passent, lint ok, pas de breaking change, couverture minimale, etc.).

Réduire les conflits entre agents

Pour éviter que deux agents modifient les mêmes fichiers de manière concurrente, assignez des zones claires : un agent sur l’implémentation, un autre sur les tests dans un dossier séparé, un autre sur la documentation. Si un conflit est inévitable, imposez une règle : un seul agent “écrit” et les autres “proposent” via recommandations.

Intégration avec CLI, IDE et cloud : comment construire un setup cohérent

OpenAI mentionne des rate limits doublés sur l’app, le CLI, l’IDE et le cloud pour les paid tiers. L’intérêt est de construire une chaîne de valeur où chaque surface a un rôle :

App macOS : orchestration, suivi des agents, consolidation des sorties.

IDE : exécution locale, navigation rapide, corrections manuelles, débogage.

CLI : tâches répétables, scripts, automatisation, intégration dans le terminal de l’équipe.

Cloud : exécutions plus lourdes, CI/CD, jobs de vérification ou d’analyse à grande échelle.

Un modèle d’organisation simple

Gardez les décisions dans un seul endroit. Par exemple, utilisez l’app Codex comme “source of truth” pour les missions et les résultats, et utilisez l’IDE/CLI pour exécuter et vérifier. Ainsi, vous évitez l’effet “les infos sont dispersées”.

Mesurer le ROI : vitesse, qualité, et réduction du risque

Pour piloter l’adoption, définissez quelques métriques concrètes :

Temps de cycle : du ticket au merge.

Taux de rework : nombre de retours en review et corrections post-merge.

Qualité : couverture de tests ajoutée, baisse des bugs, incidents en production.

Standardisation : présence systématique d’une checklist de validation, d’un changelog, et de tests pertinents.

Le multi-agents est particulièrement efficace quand vous standardisez un process “implementation → tests → review → docs” au lieu de traiter ces étapes comme optionnelles.

Conclusion

Avec l’app Codex pour macOS, OpenAI pousse une évolution majeure : passer d’une assistance confinée à l’IDE/terminal à une orchestration multi-agents, capable d’exécuter plusieurs missions en parallèle. Pour les utilisateurs Free et Go, l’inclusion limitée dans le temps est une opportunité de tester des workflows structurés. Pour les paid tiers, les rate limits doublés à travers l’app, le CLI, l’IDE et le cloud rendent le parallèle réellement exploitable à grande échelle. La meilleure façon d’en tirer parti est de cadrer chaque agent avec un brief clair, des contraintes et des critères d’acceptation, puis de mesurer l’impact sur le temps de cycle et la qualité. Si vous adoptez cette discipline, Codex devient moins un gadget qu’un levier opérationnel pour livrer plus vite, avec moins de risques.